Zolang ik al gefascineerd ben door de digitale wereld, boeit de kruising van taal en technologie me. De digitale wereld draait op woorden – of ze nu gesproken of geschreven zijn. Toch gaat spreken al millennia langer mee dan schrijven, en heeft het menselijke interactie gevormd lang voordat het geschreven woord zijn intrede deed. Dit leidde ertoe dat ik onderzocht hoe informatie is gestructureerd, vooral nu we een heropleving van de mondelinge cultuur zien dankzij vooruitgangen in AI-technologieën zoals Automatic Speech Recognition (ASR/StT) en tekst-naar-spraak (TtS).

Inhoudsopgave

In mijn verkenning ontdekte ik dat hoewel tekst compact blijft, gemakkelijker op te slaan is en beter doorzoekbaar, gesproken taal nuances bevat – intonatie, emotie en zelfs de subtiliteiten van lichaamstaal – die tekst vaak verliest. Deze verschuiving naar een mondelinge communicatiewijze, gefaciliteerd door AI, intrigeerde me, vooral omdat het de grens tussen spreken en schrijven vervaagt.

De Terugkeer naar Mondelinge Cultuur door AI

Met tools zoals ASR en TtS zien we een gedeeltelijke terugkeer naar een mondelinge cultuur in onze digitale ruimtes. Ik wilde begrijpen hoe ik naadloos kon schakelen tussen de twee modi – spraak en tekst.

Dit onderzoek groeide uit tot een fascinerende reis. Ik ben tot het inzicht gekomen dat dictatie, hoewel sneller dan typen, het beste werkt wanneer je een helder idee hebt van wat je wilt zeggen. Als je gedachten meer vloeiend of onderzoekend zijn, kan opnemen en dan transcriberen nog steeds de betere aanpak zijn.

Het belangrijkste verschil tussen ASR (Automatic Speech Recognition) en STT (Speech-to-Text) ligt in hun reikwijdte: StT richt zich uitsluitend op het transcriberen van gesproken woorden naar tekst, vaak resulterend in een platte, woordelijke weergave. ASR omvat daarentegen een breder scala aan mogelijkheden, zoals spreker diarisation, timestamping, meertalige ondersteuning en contextueel begrip, wat het ideaal maakt voor verrijkte outputs zoals gestructureerde transcripties of media-klare content. Terwijl StT voldoende is voor basistranscriptie, biedt ASR geavanceerde verwerking voor meer complexe toepassingen.

De Tools Achter Mijn Workflow

Ik heb geëxperimenteerd met verschillende tools om te ontdekken wat het beste werkt voor mijn behoeften:

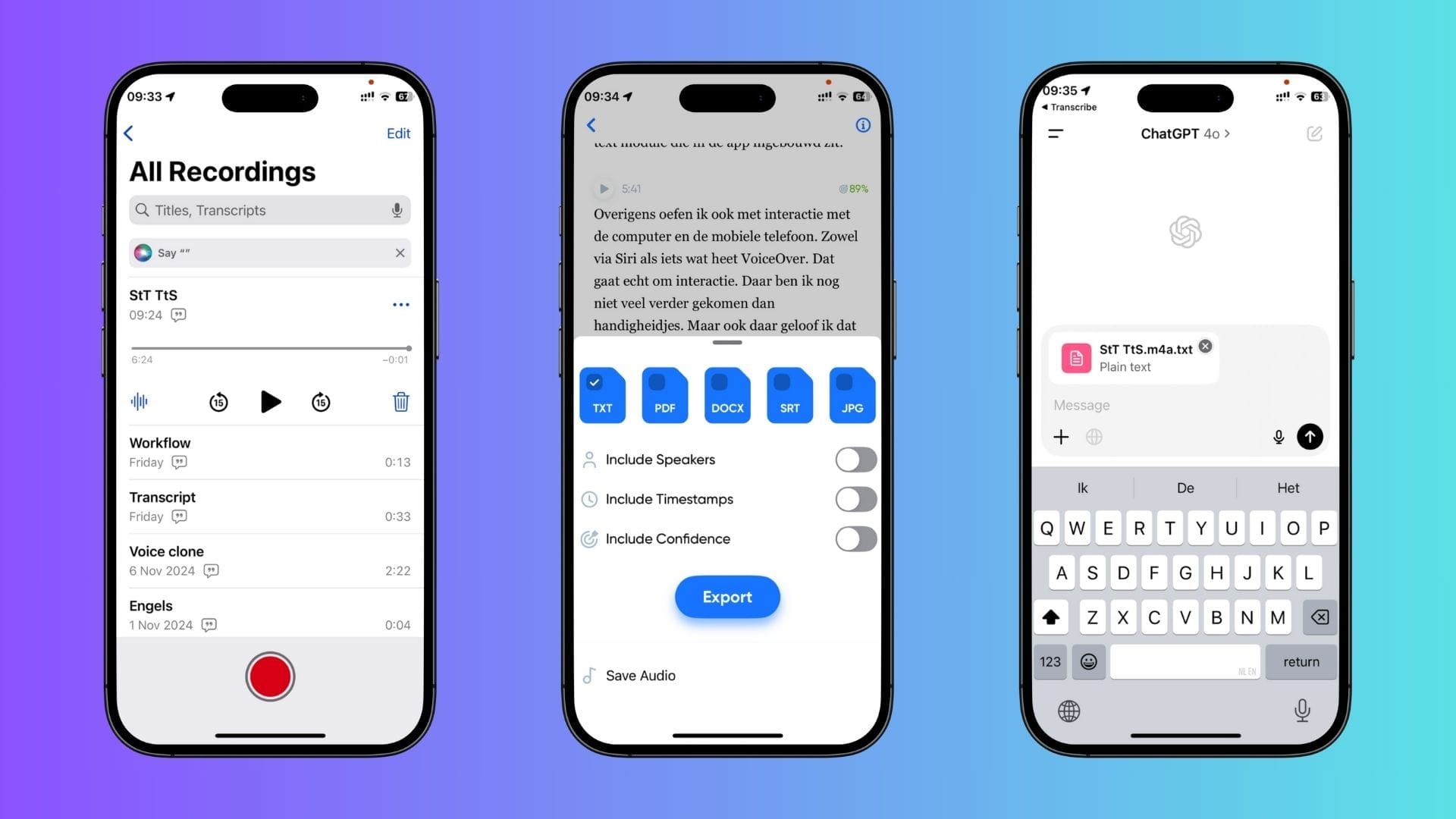

- Transcriptie: Ik gebruik drie methoden voor transcriptie: lokaal, cloud-gebaseerd en voor videogesprekken. Lokaal gebruik ik OpenAI’s Whisper, dat alles op mijn apparaat houdt, waardoor privacy en controle over mijn data gewaarborgd zijn. Voor cloud-gebaseerde transcriptie gebruik ik een applicatie genaamd Transcribe, die apparaatoverschrijdend is en flexibiliteit biedt in toegang tot mijn transcripties waar ik ze ook nodig heb. Voor videogesprekken gebruik ik Fireflies, dat automatisch mijn gesprekken opneemt en transcribeert, inclusief sprekersvolging – een functie die onderscheidt wie wat zei. Deze combinatie is ongelooflijk nuttig geweest voor projecten die gedetailleerde dialooganalyse vereisten.

- Spraaksynthese: Naast transcriptie heb ik me verdiept in de wereld van spraaksynthese. Ik heb zelfs een kloon van mijn stem gemaakt, waardoor ik gesproken content kan genereren die persoonlijker aanvoelt en meer verbonden is met mijn stijl. Dit is vooral handig voor projecten waar ik regelmatig content moet bijwerken. Bijvoorbeeld in screencast-video’s, waar de visuele beelden vaak veranderen, is het gebruik van TtS om vernieuwde vertelling te synchroniseren met nieuw beeldmateriaal veel efficiënter dan alles opnieuw opnemen.

Dictatie: Efficiëntie en Ingebouwde Functies

Een van de grootste openbaringen voor mij was de pure efficiëntie van dictatie. Ik heb ontdekt dat dictatie minstens drie keer sneller is dan typen, vooral voor langere teksten. Terwijl typen kan helpen bij concentratie, voelt dictatie natuurlijker en vloeiender aan bij het vastleggen van eerste gedachten.

Hoewel dictatie beperkingen heeft – zoals niet in volledige stilte kunnen werken – profiteert het van verbeterde lokale rekenkracht, wat het ook privéder maakt. Ironisch genoeg leidt typen op een telefoon, ondanks dat het tastbaar is, vaak tot fysieke belasting, terwijl dictatie in veel situaties comfortabeler en efficiënter is.

Ik heb ook het gemak van OS-niveau transcriptiefuncties op iOS en macOS omarmd. Doordat StT-functionaliteit direct in het systeem is geïntegreerd, kan ik er overal toegang tot krijgen, of ik nu op mijn laptop of mijn telefoon werk. Dit soort consistentie is een game-changer. Hoewel ik blijf experimenteren met platforms zoals ChatGPT’s transcriptiemogelijkheden, waardeer ik de flexibiliteit om te kunnen dicteren waar de inspiratie ook toeslaat.

Navigeren door Stembesturingen en Interactie

Naast transcriptie en synthese ben ik stemcommando’s op zowel desktop als mobiele apparaten aan het onderzoeken, met tools zoals Siri en VoiceOver. Deze experimenten zijn nog in een vroeg stadium, maar ik ben ervan overtuigd dat naarmate AI zich blijft ontwikkelen, de manier waarop we met onze apparaten omgaan dramatisch zal veranderen.

We bewegen ons weg van traditionele Grafische Gebruikersinterfaces (GUIs) naar meer natuurlijke, stemgestuurde Application Programming Interfaces (APIs). Ik ben van plan om hier dieper op in te gaan in toekomstige berichten.

Een Nieuwe Manier van Werken

Uiteindelijk heeft mijn reis in StT en TtS me geleerd dat deze technologieën niet alleen om efficiëntie draaien; ze vertegenwoordigen een nieuwe manier van werken, een manier die meer in overeenstemming is met de natuurlijke flow van menselijke communicatie. Door gesproken en geschreven modaliteiten te mengen, kunnen we effectiever communiceren, onze workflows stroomlijnen en ons aanpassen aan het evoluerende digitale landschap.

Ik ben nog steeds aan het leren, nog steeds aan het oefenen, maar ik zie een toekomst waarin spraak en tekst naadloos naast elkaar bestaan, waardoor we minder op de tools zelf hoeven te focussen en meer op de boodschappen die we willen delen.

Een van de uitdagingen met dictatiesoftware is de inconsistentie in het omgaan met eigennamen zoals bedrijfsnamen, stadsnamen en persoonsnamen. Deze systemen missen vaak de juiste interpretatie of spelling van unieke namen, wat leidt tot extra correcties. Verrassend genoeg ontbreekt het de meeste dictatietools aan een gepersonaliseerde woordenboekfunctie waarin gebruikers vaak gebruikte namen kunnen opslaan voor meer nauwkeurige herkenning. Een ander probleem doet zich voor bij meertalige gebruikers: terwijl sommige software probeert de gesproken taal automatisch te detecteren, is dat niet altijd betrouwbaar. Dit kan leiden tot frustratie bij het schakelen tussen talen, aangezien het systeem mogelijk naar de verkeerde taal overschakelt. Een echt naadloze ervaring zou automatische taalherkenning per zin kunnen omvatten, of op zijn minst een snellere manier om onderweg van taal te wisselen.